In un’epoca in cui l’Intelligenza Artificiale (IA) e le applicazioni che fanno uso di grandi quantità di contenuti testuali stanno crescendo a ritmi esponenziali, l’efficienza di memorizzazione, ricerca e recupero diventa cruciale. La libreria Memvid propone un approccio originale: trasformare una base di conoscenza testuale in un file video (MP4) contenente QR code, e renderla interrogabile semanticamente in millisecondi, senza bisogno di un database tradizionale. GitHub

Questo articolo approfondisce come funziona, quali vantaggi offre, le possibili limitazioni e alcuni scenari di utilizzo.

Cos’è Memvid

Memvid è una libreria open-source in Python (richiede Python 3.8+). GitHub

Obiettivo: “Store millions of text chunks in MP4 files with lightning-fast semantic search. No database needed.” GitHub

In altre parole, anziché usare un motore di database vettoriale (vector DB) + infrastruttura dedicata, Memvid codifica i chunk testuali come immagini (QR code) che vengono inserite in un video utilizzando un codec video moderno. In fase di ricerca, si esegue un embedding della query, si mappa a un frame del video, si decodifica e si restituisce il risultato.

Perché “video”?

Secondo gli autori, i motivi sono:

- I codec video moderni (H.264, H.265/HEVC, AV1) sono estremamente efficienti nel comprimere pattern visivi ripetitivi (ad esempio QR code generati da testi). GitHub

- Il formato MP4 è praticamente universale, portabile, non richiede infrastrutture complesse: basta un file video + un indice. GitHub

- Il recupero può essere estremamente veloce: “Sub-100 ms retrieval for 1 M chunks (includes decode)”. GitHub

- È un approccio “offline‐first”: dopo l’encoding, tutto può avvenire localmente, senza dipendere da servizi esterni. GitHub

Architettura e funzionamento tecnico

Vediamo passo-passo come Memvid implementa il suo flusso.

1. Divisione in chunk e generazione degli embeddings

Prima di tutto, i testi vengono spezzettati (chunked) in unità più piccole, tipicamente qualche centinaio di parole o frasi. Durante l’encoding, si crea un embedding (ad esempio tramite modelli come sentence-transformers) per ciascun chunk. GitHub

Questo embedding serve per la ricerca semantica: data una query, si calcola l’embedding e si confronta con quelli già presenti, per trovare i chunks più rilevanti.

2. Codifica come QR code + video

Ogni chunk viene convertito in un QR code (o potentemente una immagine codificata) che rappresenta il testo del chunk stesso. GitHub

Queste immagini vengono poi impilate nei frame di un video MP4: si definiscono parametri come fps, dimensione del frame, codec, fattore di compressione (crf) etc. Esempio riportato:

encoder.build_video(

"compressed.mp4",

"index.json",

fps=60,

frame_size=256,

video_codec='h265',

crf=28)

``` :contentReference[oaicite:10]{index=10}

Parallelamente, viene creato un indice (`index.json`) che mappa embedding → numero di frame del video.

### 3. Ricerca semantica e recupero

Quando l’utente effettua una query:

- Viene calcolato l’embedding della query.

- L’embedding viene confrontato con l’indice per trovare il migliore match (cioè il frame o i frame corrispondenti).

- Si effettua un seek diretto al frame nel file video, decodifica del QR code, e restituzione del chunk di testo.

In questo modo la ricerca è **più rapida** rispetto a un’interrogazione su database tradizionale. :contentReference[oaicite:11]{index=11}

### 4. Parametri e scalabilità

Alcune delle opzioni configurabili:

- `chunk_size`: dimensione dei pezzi di testo da indicizzare.

- `n_workers`: numero di thread/processi per l’encoding parallelo. :contentReference[oaicite:12]{index=12}

- Codec video: è possibile scegliere H.265 (HEVC), AV1 (in futuro) per ottenere compressioni migliori. :contentReference[oaicite:13]{index=13}

- Frame size e fps: influenzano la dimensione del video e la qualità dell’indicizzazione.

### 5. Performance dichiarate

Gli sviluppatori riportano:

> “Indexing: ~10K chunks/second on modern CPUs” :contentReference[oaicite:14]{index=14}

> “Search: <100ms for 1 M chunks (includes decode)” :contentReference[oaicite:15]{index=15}

> “Storage: 100 MB text → 1-2 MB video” (dipende dalla compressione) :contentReference[oaicite:16]{index=16}

> “Memory: Constant 500 MB RAM regardless of size” :contentReference[oaicite:17]{index=17}

Questi numeri – se confermati in produzione – possono risultare davvero molto vantaggiosi per certe applicazioni.

---

## Vantaggi e scenari di utilizzo

### Vantaggi principali

- **Portabilità**: Un file MP4 + un indice JSON è facile da distribuire, copiare, versionare.

- **Infrastruttura minima**: Non serve un cluster di database, né servizi esterni: solo Python e il file video.

- **Elevata compressione**: Per certi usi, l’approccio “text → QR → video” sembra dare compressioni superiori alle tradizionali banche vettoriali.

- **Ricerca veloce**: Seek diretto al frame, poca latenza.

- **Offline-first**: Ideale per dispositivi embedded, edge, o ambienti dove la connessione è limitata.

### Scenari di utilizzo

- Sistemi di knowledge base leggeri che debbano essere distribuiti con facilità (es. applicazioni desktop, dispositivi edge).

- Ambienti embedded con risorse limitate, dove non ha senso far girare un intero database vectoriale.

- Documentazione, PDF, manuali tecnici indicizzati per ricerca semantica interna.

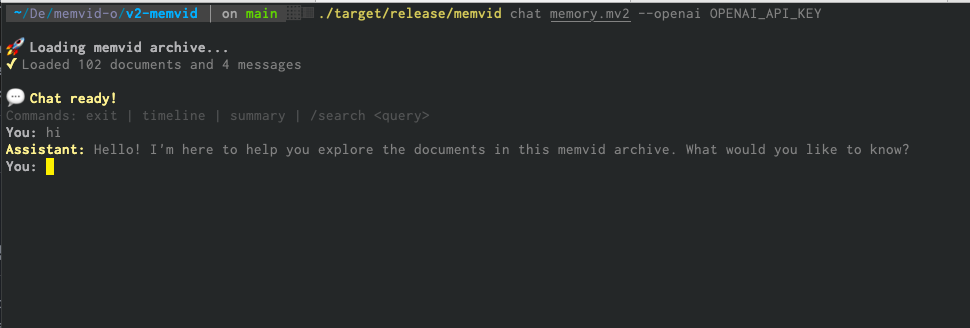

- Prototipazione rapida di application memory per chatbots, assistenti AI, dove la dimensione e la portabilità della memoria sono rilevanti.

### Considerazioni pratiche

- Se hai già una infrastruttura con database vettoriale e cluster dedicati, l’adozione di Memvid va valutata in funzione del contesto (costi, performance, scalabilità).

- Per set di dati molto grandi (decine di milioni di chunks), occorre testare concretamente la compressione, la latenza, e la gestione del file video (seek, decodifica).

- La libreria è ancora “experimental” come riportato dagli autori (“Memvid v1 is still experimental. The file format and API may change until we lock in a stable release.”) :contentReference[oaicite:18]{index=18}

---

## Come integrarla (guida rapida)

Ecco un esempio base su come iniziare con Memvid:

```python

from memvid import MemvidEncoder, MemvidChat

# Creazione della memoria

chunks = [

"NASA founded in 1958",

"Apollo 11 landed in 1969",

"ISS launched in 1998"

]

encoder = MemvidEncoder()

encoder.add_chunks(chunks)

encoder.build_video("space.mp4", "space_index.json")

# Interrogazione della memoria

chat = MemvidChat("space.mp4", "space_index.json")

response = chat.chat("When did humans land on the moon?")

print(response) # dovrebbe rispondere circa “1969” in base al chunk Apollo 11.

Parametri utili

chunk_size: consente di definire la dimensione del chunk (es. 512 parole) quando si indicizza testo da file. GitHubn_workers: per elaborazioni parallele.fps,frame_size,video_codec,crf: parametri di encoding video per ottimizzare compressione vs qualità. GitHub- Possibilità di usare modelli custom per embedding, ad esempio tramite

sentence_transformers. GitHub

File generati

- Il file video (es.

knowledge.mp4) che contiene tutti i chunk codificati. - L’indice JSON (es.

index.json) che mappa embeddings → numeri di frame. - Eventuali file accessori (file di log, cache, ecc) a seconda dell’uso.

Limiti e domande aperte

- La codifica come QR + video funziona bene finché i chunk non diventano troppo grandi o complessi; potrebbe esserci un trade-off tra velocità, accuratezza e compressione.

- La ricerca vettoriale classica ha messo a punto sofisticati algoritmi per “annidare” embedding, usare ANN (approximate nearest neighbours) e clusterizzazione; Memvid utilizza un approccio più diretto (index → frame) che andrà valutato in scenari reali.

- Cosa succede in caso di aggiornamenti dinamici della “memoria”? Al momento della v1 è più orientata a “build once, query many” piuttosto che modifiche real-time. Si parla nella roadmap della v2 di “streaming ingest: Add to videos in real-time”. GitHub

- Il formato video può diventare pesante o difficile da gestire se la memoria cresce moltissimo: bisognerà considerare eventuali limiti hardware (seek, decodifica) e la frammentazione del video.

- Essendo sperimentale, bisogna tener conto delle evoluzioni API e della stabilità futura.

Conclusione

Memvid propone una soluzione davvero innovativa e “fuori dagli schemi” per il problema della memorizzazione e ricerca semantica di grandi basi testuali: convertire la memoria in un file video portabile, altamente compresso, e facilmente distribuibile.

Per molti scenari — specialmente quelli dove la semplicità dell’infrastruttura, la portabilità o l’edge computing sono un requisito — può rappresentare una alternativa interessante ai database vettoriali tradizionali.